Yolov8关于创新点的讨论

L如果你害怕失敗,那你很有可能會失敗。 If you’re afraid to fail, then you’re probably going to fail.

Yolov8关于创新点的讨论

移动检测应用

通过上传模型到roboflow网站,roboflow提供api接口就可以在本地进行推理。

同时,通过ios的sdk,可以在移动端上进行推理。

from inference import InferencePipeline

from inference.core.interfaces.stream.sinks import render_boxes

pipeline = InferencePipeline.init(

api_key="*****",

model_id="******",

video_reference="./pipelinecrack.mp4",

on_prediction=render_boxes,

)

pipeline.start()

pipeline.join()像是unix/linux环境

命令行直接执行下面命令也可以进行本地推理。

inference infer -i "./pipelinecrack.mp4" -m "*****" -o "./out.mp4" --api-key "****"__*号表示模型和密钥 __

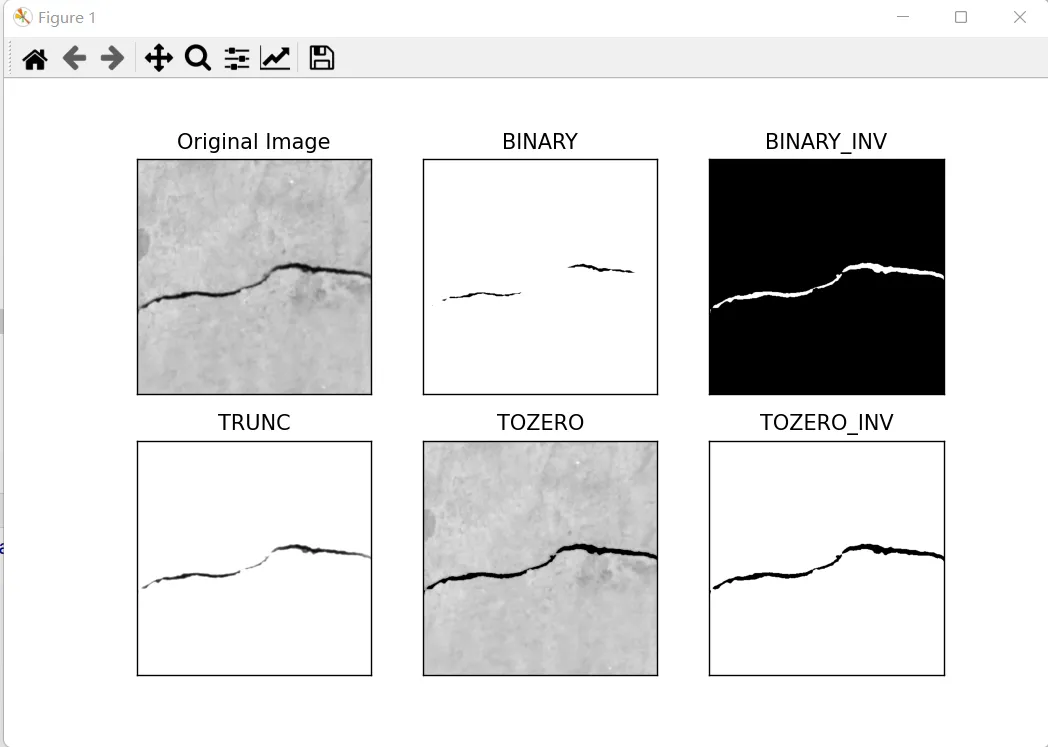

opencv对数据集的预处理

方法一:阈值分割

import cv2 as cv

import numpy as np

from matplotlib import pyplot as plt

img = cv.imread('../data/lf2.png',0)

cv.imshow("temp",img)

ret,thresh1 = cv.threshold(img,45,255,cv.THRESH_BINARY)

print(ret)

ret,thresh2 = cv.threshold(img,127,255,cv.THRESH_BINARY_INV)

print(ret)

ret,thresh3 = cv.threshold(img,127,255,cv.THRESH_TRUNC)

print(ret)

ret,thresh4 = cv.threshold(img,127,255,cv.THRESH_TOZERO)

print(ret)

ret,thresh5 = cv.threshold(img, 127, 255, cv.THRESH_BINARY + cv.THRESH_OTSU)

print(ret)

titles = ['Original Image','BINARY','BINARY_INV','TRUNC','TOZERO','TOZERO_INV']

images = [img, thresh1, thresh2, thresh3, thresh4, thresh5]

for i in range(6):

plt.subplot(2,3,i+1),plt.imshow(images[i],'gray')

plt.title(titles[i])

plt.xticks([]),plt.yticks([])

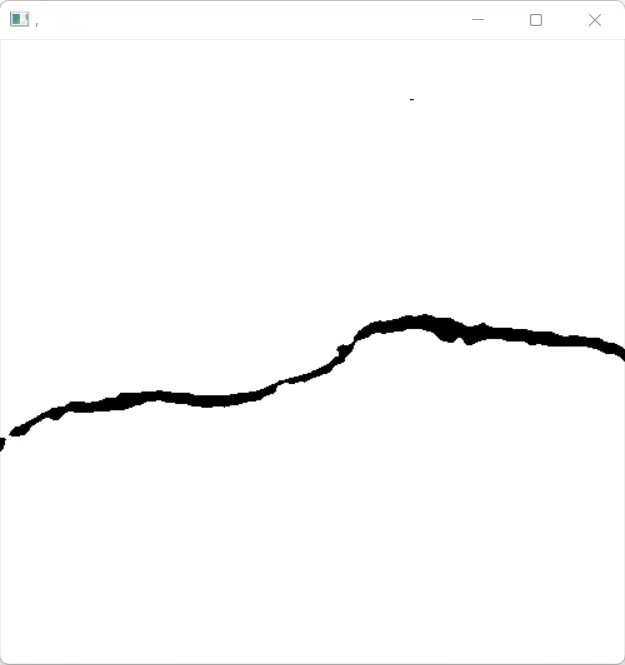

plt.show()方法二:区域生长算法

import cv2

import numpy as np

def regionGrow(img, seeds, avg_seed, thresh):

''' 进行区域生长'''

m, n = img.shape

result_img = np.zeros_like(img) # 定义保存结果图像的变量

connection = [(-1, -1), (-1, 0), (-1, 1), (0, 1), (0, -1), (1, -1), (1, 0), (1, 1)] # 定义种子点的邻域

while (len(seeds) != 0): # 只要种子向量不为空,就一直在生长

pt = seeds.pop()

result_img[pt[0], pt[1]] = 255

for i in range(8): # 迭代8连通邻域的所有像素

x = pt[0] + connection[i][0]

y = pt[1] + connection[i][1]

if x < 0 or y < 0 or x >= m or y >= n: # 判断是否超出了图像边界

continue

# 判断是否满足相似性准则

if (abs(int(img[x, y]) - int(avg_seed)) < thresh and result_img[x, y] == 0):

result_img[x, y] = 255 # 标记满足要求的像素点

seeds.add((x, y)) # 将像素点加到种子向量中

result_img = result_img.astype('uint8')

return result_img

img = cv2.imread('../data/lf2.png')

# cv2.imshow(',,', gray_img)

gray_img = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

m, n = gray_img.shape

seed_set = set()

seed_set.add((81, 293))

sum_seed = 0

for item in seed_set:

sum_seed += gray_img[item[0], item[1]]

avg_seed = round(sum_seed / len(seed_set))

result_img = regionGrow(gray_img, seed_set, avg_seed, 50)

index = (result_img == 0)

img = np.ones([m,n])

img[index] = 0

cv2.imshow(',', img)

cv2.waitKey(0)

cv2.destroyAllWindows()区域生长是一种基于种子点(种子集合)的分割方法,它通过将与种子点具有相似性的邻域像素加入到种子集合中,从而将图像分割成不同的区域。以下是代码的步骤说明:

- 定义区域生长函数

regionGrow,该函数接受以下参数:

- img:待处理的灰度图像。

- seeds:种子点的集合,用于初始化生长过程。

- avg_seed:种子点的平均灰度值,用于相似性判断。

- thresh:相似性阈值,用于确定哪些邻域像素可以被加入到种子集合中。

- 读取图像

cv2.imread('../data/lf2.png')并将其转换为灰度图像gray_img。 - 初始化种子集合

seed_set,并将一个种子点(81, 293)添加到集合中。 - 计算种子点的平均灰度值

avg_seed。 - 调用

regionGrow函数进行区域生长,得到结果图像result_img。 - 将结果图像中的黑色像素点(值为0)在原始彩色图像中对应的像素点设置为白色(值为0)。

- 使用

cv2.imshow显示处理后的图像,并等待按键后关闭窗口。

以下代码均为伪代码

1. 数据增强与合成

数据增强

数据增强技术可以显著提高模型的鲁棒性,常见的增强方法包括:

- 旋转:在一定角度范围内随机旋转图像。

- 缩放:随机缩放图像大小。

- 裁剪:随机裁剪图像的一部分。

- 翻转:水平或垂直翻转图像。

- 添加噪声:在图像中添加随机噪声。

- 颜色变换:随机改变图像的亮度、对比度和饱和度。

例如,在Python中使用Albumentations库可以轻松实现这些增强方法:

import albumentations as A

from albumentations.pytorch import ToTensorV2

transform = A.Compose([

A.RandomRotate90(),

A.Flip(),

A.Transpose(),

A.OneOf([

A.IAAAdditiveGaussianNoise(),

A.GaussNoise(),

], p=0.2),

A.OneOf([

A.MotionBlur(p=0.2),

A.MedianBlur(blur_limit=3, p=0.1),

A.Blur(blur_limit=3, p=0.1),

], p=0.2),

A.ShiftScaleRotate(shift_limit=0.0625, scale_limit=0.2, rotate_limit=45, p=0.2),

A.OneOf([

A.OpticalDistortion(p=0.3),

A.GridDistortion(p=0.1),

A.IAAPiecewiseAffine(p=0.3),

], p=0.2),

A.OneOf([

A.CLAHE(clip_limit=2),

A.IAASharpen(),

A.IAAEmboss(),

A.RandomBrightnessContrast(),

], p=0.3),

A.HueSaturationValue(p=0.3),

ToTensorV2(),

])合成数据

合成数据可以增加数据集的多样性,尤其是在数据不足时非常有用。你可以使用计算机图形学技术生成合成裂缝图像,例如Blender或其他3D建模工具。

2. 多尺度检测

多尺度训练

通过使用不同尺度的输入图像进行训练,可以使模型更好地适应不同尺寸的裂缝。例如,在训练时可以随机缩放输入图像。

scales = [0.5, 1.0, 1.5]

for epoch in range(num_epochs):

for images, targets in dataloader:

scale = random.choice(scales)

images = F.interpolate(images, scale_factor=scale, mode='bilinear')

outputs = model(images)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()多尺度预测

在推理阶段,可以使用多尺度的输入图像进行检测,并融合结果以提高检测精度。

scales = [0.5, 1.0, 1.5]

results = []

for scale in scales:

scaled_images = F.interpolate(images, scale_factor=scale, mode='bilinear')

outputs = model(scaled_images)

results.append(outputs)

final_results = merge_results(results)3. 自监督学习与迁移学习

自监督学习

自监督学习可以在没有标签的大量数据上预训练模型。例如,使用自编码器或对比学习方法预训练模型,然后将这些特征用于裂缝检测任务。

from simclr import SimCLR

model = SimCLR(base_model='resnet50')

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3)

for epoch in range(num_epochs):

for images in dataloader:

loss = model(images)

optimizer.zero_grad()

loss.backward()

optimizer.step()迁移学习

从预训练的模型(例如,在ImageNet上训练的ResNet)进行迁移学习,可以利用其强大的特征提取能力。

import torchvision.models as models

model = models.resnet50(pretrained=True)

model.fc = nn.Linear(model.fc.in_features, num_classes)

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=1e-4)

for epoch in range(num_epochs):

for images, labels in dataloader:

outputs = model(images)

loss = criterion(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()4. 结合其他传感器数据

使用多模态数据融合技术,将视觉数据与其他传感器数据(如红外成像、超声波检测)结合,能够增强模型的检测能力。例如,可以将多模态数据输入到一个多输入模型中进行联合训练。

class MultiModalNet(nn.Module):

def __init__(self):

super(MultiModalNet, self).__init__()

self.visual_branch = models.resnet50(pretrained=True)

self.infrared_branch = models.resnet50(pretrained=True)

self.fc = nn.Linear(self.visual_branch.fc.in_features + self.infrared_branch.fc.in_features, num_classes)

def forward(self, x_visual, x_infrared):

x_visual = self.visual_branch(x_visual)

x_infrared = self.infrared_branch(x_infrared)

x = torch.cat((x_visual, x_infrared), dim=1)

x = self.fc(x)

return x5. 在线学习与自适应学习

在线学习

设计一个系统,使模型能够在实际应用中不断从新数据中学习和改进。例如,可以使用在线学习算法在新数据到达时更新模型。

from sklearn.linear_model import SGDClassifier

model = SGDClassifier()

for new_data, new_labels in data_stream:

model.partial_fit(new_data, new_labels, classes=classes)自适应学习

使模型能够根据环境和条件的变化自动调整自身参数,例如使用域自适应技术。

from torch.utils.data import DataLoader

from dann import DomainAdversarialNN

source_loader = DataLoader(source_dataset, batch_size=batch_size, shuffle=True)

target_loader = DataLoader(target_dataset, batch_size=batch_size, shuffle=True)

model = DomainAdversarialNN()

for epoch in range(num_epochs):

for (source_data, source_labels), (target_data, _) in zip(source_loader, target_loader):

loss = model(source_data, source_labels, target_data)

optimizer.zero_grad()

loss.backward()

optimizer.step()6. 高效模型压缩与部署

模型压缩

使用模型剪枝、量化和知识蒸馏等技术,减少模型的计算复杂度和内存占用。

import torch.quantization

model = models.resnet50(pretrained=True)

model.eval()

model_fused = torch.quantization.fuse_modules(model, [['conv1', 'bn1', 'relu']])

model_int8 = torch.quantization.convert(model_fused)边缘计算与云端协同

在边缘设备上进行初步检测,然后将结果传送到云端进行进一步处理和分析。

edge_result = edge_device.detect(image)

if edge_result.confidence < threshold:

cloud_result = cloud_server.analyze(image)7. 开发用户友好的检测系统

实时监控与报警系统

开发一个实时监控系统,结合YOLOv8模型进行实时裂缝检测,并在检测到裂缝时自动发出警报。

import cv2

cap = cv2.VideoCapture(0)

while True:

ret, frame = cap.read()

if not ret:

break

results = model(frame)

if results.contains_crack():

alert_system.trigger_alarm()

cv2.imshow('Crack Detection', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()可视化工具

开发一个交互式的可视化工具,帮助用户直观地查看检测结果和裂缝位置。

import dash

import dash_core_components as dcc

import dash_html_components as html

app = dash.Dash(__name__)

app.layout = html.Div([

dcc.Graph(id='crack-detection-results')

])

@app.callback(

Output('crack-detection-results', 'figure'),

Input('image-upload', 'contents')

)

def update_graph(contents):

image = parse_contents(contents)

results